Reach 2024: Élucider la causalité

PAR KATHLEEN SANDUSKY

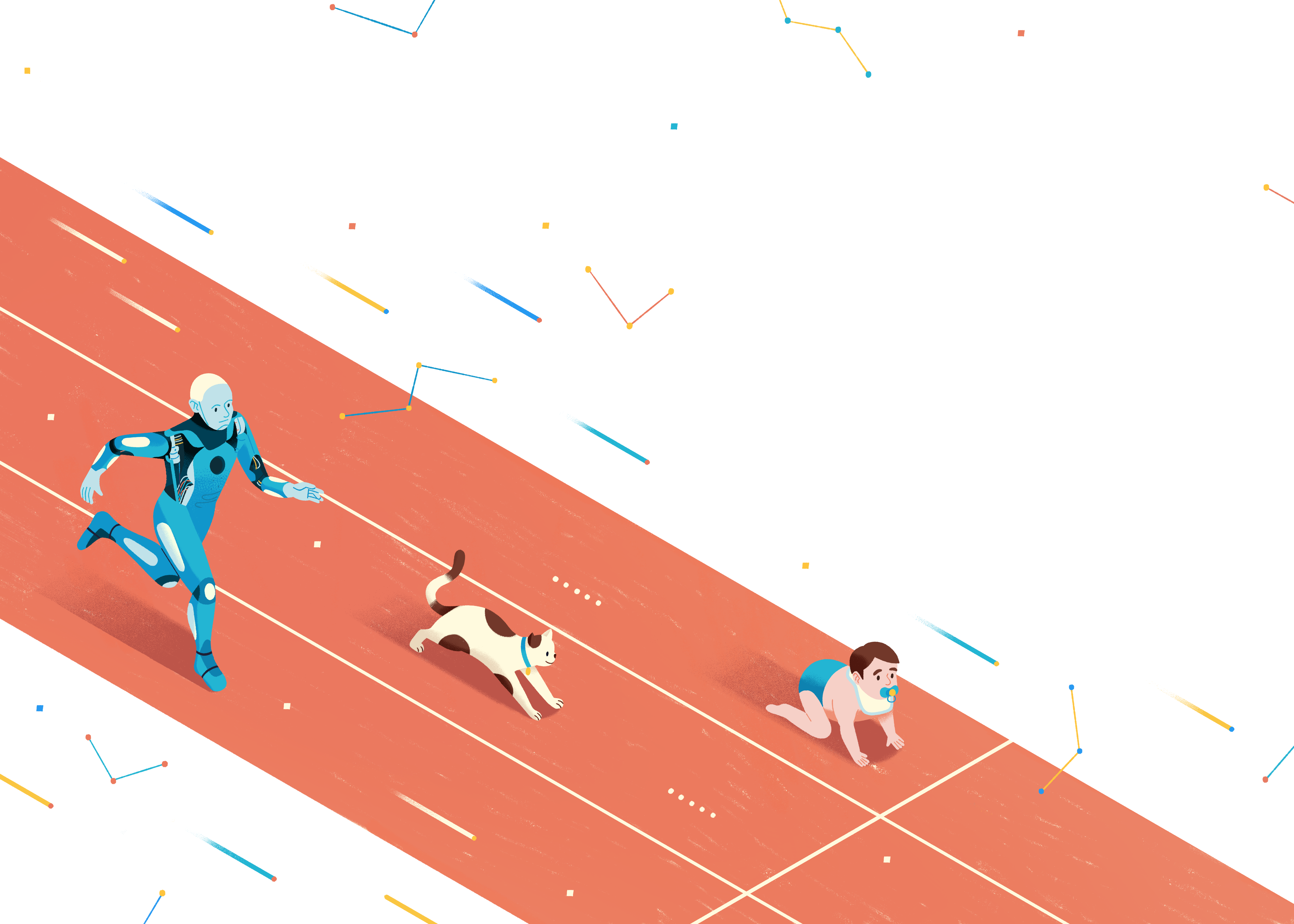

Pourquoi le cerveau excelle-t-il à percevoir les liens de causalité (et que faut-il à l’IA pour rattraper son retard)?

ILLUSTRATION PAR MAYA NGUYEN

Les bébés comprennent ces liens, même les chats et les corbeaux semblent en avoir une connaissance pratique. Pourtant, malgré d’énormes avancées, les systèmes d’intelligence artificielle actuels ont du mal à comprendre la causalité, c’est-à-dire la relation entre la cause et l’effet.

Pourquoi le cerveau humain est-il si doué pour interpréter la causalité? Que peut nous apprendre la neuroscience sur la causalité pour aider l’IA et vice versa? Quels sont les enjeux?

Pour répondre à ces questions pressantes, nous avons demandé à trois scientifiques du CIFAR de nous faire part de leurs réflexions.

ALISON GOPNIK

Université de la Californie à Berkeley

Membre, Développement du cerveau et de l’enfant, et Apprentissage automatique, apprentissage biologique

Alison Gopnik est une sommité dans l’étude des sciences cognitives ainsi que de l’apprentissage et du développement des enfants. Dans ses plus récentes recherches, elle conjugue l’«histoire de la vie» en biologie évolutive et les recherches actuelles en IA pour expliquer comment les enfants pensent et apprennent.

Photo: Winni Wintermeyer

Q : Quels sont les obstacles scientifiques à la compréhension de la causalité dans le cerveau humain et animal? Peut-on transférer ces connaissances à l’IA?

ALISON GOPNIK : En tant qu’êtres pensants, l’une des choses les plus importantes à faire est d’apprendre à connaître les relations de cause à effet. Il s’agit d’un problème important pour la science, en fait le problème central. Quand les adultes essaient de résoudre des problèmes de causalité au quotidien, ils s’appuient principalement sur les données déjà disponibles. Il s’agit notamment d’informations élémentaires, comme le fait que si j’ouvre un robinet, de l’eau en sortira. Mais dans le cas des enfants et des scientifiques, l’information nécessaire est absente. Ils doivent l’acquérir d’une manière ou d’une autre à partir des modèles qu’ils observent dans le monde. C’est un problème que tout système véritablement intelligent, qu’il soit biologique ou informatique, devra résoudre, et les enfants semblent être les plus doués en la matière. Voilà pourquoi, depuis plus de 20 ans, nous examinons comment les enfants résolvent ce problème.

Q : Dans le domaine de la psychologie du dévelop-pement, vous êtes connu pour le «blicket». Pouvez-vous nous en parler?

AG : Le détecteur de «blicket » est une petite boîte qui s’allume et joue de la musique lorsqu’on dépose certains objets dessus, mais pas d’autres. Nous demandons à l’enfant : Lequel est un blicket? Peux-tu me dire comment ça fonctionne? Peux-tu l’activer? Grâce à cette machine très simple, nous pouvons présenter aux enfants différents modèles de données et voir les conclusions qu’ils en tirent. Au début, nous manipulions les objets pour eux. Mais nous avons rapidement observé que les enfants voulaient toujours toucher les blickets eux-mêmes et les essayer sur la machine. Ils voulaient jouer avec eux. Ils ne veulent pas regarder, ils veulent faire. En science, le travail des scientifiques consiste parfois à examiner de gigantesques bases de données et à essayer d’en tirer des statistiques, ce qui revient en quelque sorte à ce que font la plupart des systèmes d’IA à réseaux neuronaux actuels. On leur donne un énorme ensemble de données et on leur demande d’en extraire la structure. Mais la référence en science, ce sont les expériences contrôlées, les relations de cause à effet qui manipulent réellement quelque chose dans le monde pour en découvrir le fonctionnement. Nous essayons de voir si nous pouvons examiner l’apprentissage actif des enfants – la façon dont ils expérimentent, jouent et font des choses dans le monde – et rendre compte de ces processus par des méthodes informatiques.

« En tant qu’êtres pensants, l’une des choses les plus importantes à faire est d’apprendre à connaître les relations de cause à effet. Il s’agit d’un problème important pour la science, en fait le problème central. »

– Alison Gopnik

Q : Un débat persiste : l’intelligence artificielle sera-t-elle capable d’accomplir aussi bien, voire mieux, que les êtres humains une série de tâches cognitives, manifestant ainsi ce que l’on appellerait «l’intelligence artificielle générale» (IAG)? Sur une échelle de 1 à 10, 1 étant impossible et 10 certain, quelle est la probabilité que l’IAG voie le jour d’ici dix ans?

AG : En ma qualité de psychologue du développement, je ne pense pas que l’IAG puisse exister, je dirai donc zéro. Plus nous étudions les enfants, plus nous nous rendons compte que même les tâches cognitives les plus simples, que nous tenons pour acquises, sont d’une incroyable complexité. Et nous ne comprenons pas vraiment comment les enfants apprennent autant qu’ils le font, aussi rapidement qu’ils le font. Je doute que nous puissions résoudre ce problème et l’appliquer à des agents artificiels d’ici dix ans ou plus. Cela dit, l’IA deviendra beaucoup plus compétente dans l’exécution de tâches spécialisées. Je pense que son rôle en tant que technologie culturelle sera vraiment intéressant. Les êtres humains auront accès à beaucoup plus de données. Pour les êtres humains, des inventions comme l’écriture, l’impression et les moteurs de recherche sur Internet permettent de transmettre davantage d’information et d’y accéder. Il s’agit de technologies très importantes qui peuvent changer notre mode de fonctionnement. Les grands modèles de langage constituent l’exemple le plus récent d’une telle technologie : ils résument toutes les données disponibles sur Internet et permettent d’y accéder. Mais cela n’a rien à voir avec l’intelligence humaine. Je pense que l’IA est très loin d’une telle compétence.

DHANYA SRIDHAR

Université de Montréal

Titulaire de chaire en IA Canada-CIFAR, Mila

Dhanya Sridhar formule des théories et conçoit des méthodes d’apprentissage automatique pour étudier des questions de causalité. Ses recherches se concentrent sur la compréhension théorique des questions de causalité auxquelles il est possible de répondre à partir de données observées, et sur l’adaptation des méthodes d’apprentissage automatique pour estimer les effets causals. Elle conjugue la causalité et l’apprentissage automatique au service de systèmes d’IA robustes, adaptatifs et utiles à la découverte scientifique.

Photo: Dominic Blewett

Q : Pourquoi la causalité joue-t-elle un rôle si important en intelligence artificielle?

DHANYA SRIDHAR : Les êtres humains et les autres organismes semblent capables de percevoir des change-ments dans leur environnement. Nous pouvons remarquer que certaines variables, lorsqu’elles sont perturbées d’une façon quelconque, affectent l’état d’autres variables. Nous en prenons encore plus conscience lorsque ce modèle – la variable un affecte la variable deux – se produit de manière fiable, peu importe ce qui arrive aux autres variables du système. Voilà ce qu’on appelle l’invariance. L’observation d’un tel modèle de changement reproductible est qualifiée, pour des raisons pratiques, de relation de cause à effet. Le terme «cause» est donc un raccourci pour décrire les relations qui semblent robustes et stables, quelle que soit l’évolution des autres parties du système. Pourquoi est-il important et intéressant pour nous, en tant qu’organismes, de suivre les relations de cause à effet? En raison de leur invariance. Elles permettent aux organismes d’anticiper les résultats, de planifier et de réagir en conséquence. Dans le même ordre d’idées, la causalité pourrait se révéler essentielle pour les systèmes d’IA qui font des prédictions à partir de données complexes. L’identification et l’utilisation des relations causales pourraient aider les systèmes d’IA à produire des réponses robustes et fondées sur des motifs fiables.

Q : Comme la causalité est une question essentielle tant pour l’IA que pour la neuroscience, comment ces domaines peuvent-ils mutuellement apprendre et partager des connaissances sur les mécanismes de causalité?

DS : D’après ce que je comprends, les êtres humains et de nombreuses autres espèces sont capables de repérer des modèles de causalité. Lorsque nous inter- agissons avec le monde ou que nous observons d’autres personnes interagir avec le monde, nous remarquons qu’une action semble conduire à un changement d’état. Si ce changement se produit dans de nombreuses conditions différentes, nous sommes capables de reconnaître qu’il s’agit d’une sorte de « règle» causale. Mais dans notre monde complexe, la capacité à reconnaître rapidement les modèles de causalité peut aussi constituer un problème : nous, les êtres humains, attribuons malheureusement à tort la causalité à des coïncidences. Il arrive qu’un événement A se produise et soit suivi d’un événement B; nous en concluons que A a dû causer B. Le biais de confirmation peut ensuite renforcer cette vision erronée du monde. Lorsque nous considérons les algorithmes d’apprentissage, la question est de savoir s’ils sont également capables de remarquer des modèles qui restent invariables dans tous les contextes – en d’autres termes, qui restent les mêmes – et de tirer parti de ces modèles pour faire des prédictions. La détermination des relations de cause à effet aide les êtres humains à bâtir un modèle du monde hautement modulaire, comptant de nombreux éléments de connaissance qui restent inchangés, même si d’autres connaissances changent. Comme l’entraînement des grands systèmes d’apprentissage automatique se fait de plus en plus à l’aide de sources de données multiples et très diversifiées – données nécessaires à l’apprentissage de modèles de causalité – une question clé pour la recherche en IA est de savoir comment encourager les algorithmes d’apprentissage à s’accrocher à des modèles invariants.

Q : Supposons que nous résolvions ce problème de la causalité dans l’apprentissage automatique. Si l’IA parvient à comprendre la causalité, quels sont les enjeux? Quel pourrait être le résultat?

DS : L’une des réponses est ce que nous appelons la «généralisation hors distribution». Cette idée veut que les systèmes d’IA ne soient pas trop mauvais pour prédire les résultats ou prendre des décisions dans des scénarios qu’ils n’ont jamais rencontrés auparavant. Qu’entendons-nous par « pas trop mauvais »? Si les systèmes d’IA s’appuient de plus en plus sur des associations relativement stables lorsqu’ils font des prédictions, il est probable que ces relations stables persistent dans une certaine mesure dans de nouveaux contextes. Si les systèmes d’IA arrivaient à repérer des connaissances causales, un autre impact possible serait l’évitement des préjugés néfastes. Prenons l’exemple des stéréotypes racistes. On peut considérer les stéréotypes comme des associations qui ne reflètent pas, en fait, de relations de cause à effet. Par conséquent, si nous disposons de systèmes qui préfèrent modéliser des relations invariantes ou causales, ils pourraient éviter d’utiliser les stéréotypes comme raccourcis lors de la prise de décisions importantes. Dans le même ordre d’idées, les systèmes d’IA qui utilisent des relations causales pourraient être beaucoup plus dignes de confiance. Si, en tant qu’utilisatrice, je devais déployer un système d’IA dans un domaine sensible, je pourrais faire davantage confiance à un système qui se comporte de manière cohérente et qui n’est pas sensible à des détails non pertinents. Une telle garantie pourrait s’avérer particulièrement importante sachant que des personnes mal intentionnées essaieront probablement d’exploiter de telles sensibilités dans les modèles pour les amener à générer des résultats nuisibles.

« Prenons l’exemple des stéréotypes racistes. On peut considérer les stéréotypes comme des associations qui ne reflètent pas, en fait, de relations de cause à effet. Par conséquent, si nous disposons de systèmes qui préfèrent modéliser des relations invariantes ou causales, ils pourraient éviter d’utiliser les stéréotypes comme raccourcis lors de la prise de décisions importantes. »

– Dhanya Sridhar

Q : En parlant de sécurité, pensez-vous que la science de l’IA conduira à l’IAG dans les dix prochaines années, sur une échelle de 1 à 10?

DS : J’aimerais reformuler la question comme suit : les futurs systèmes d’IA sont-ils susceptibles de raisonner avec plus de robustesse que les systèmes d’aujourd’hui? Ma réponse est la suivante : ce n’est pas du tout évident. L’avenir de l’IA dépend de notre capacité, en tant que spécialistes de l’IA, à comprendre les biais et les raccourcis que les algorithmes d’apprentissage ont tendance à prendre. Si nous n’avons pas une meilleure compréhension du comportement des algorithmes d’apprentissage modernes, et si nous ne prenons pas de mesures pour les guider vers des solutions robustes à l’aide d’une théorie sur la causalité, je ne pense pas que nous puissions tenir pour acquis que les futurs systèmes d’IA seront plus robustes.

KONRAD KORDING

Université de la Pennsylvanie

Coresponsable de programme, Apprentissage automatique, apprentissage biologique

Konrad Kording cherche à comprendre le cerveau en tant que machine computationnelle. Par le recours à l’apprentissage profond pour modéliser les fonctions cérébrales, le laboratoire de Konrad Kording exploite largement les méthodes d’analyse des données, y compris l’apprentissage automatique, pour poser des questions fondamentales.

Photo: Colin Lenton

Q : Vos travaux chevauchent la neuroscience et l’IA. Que pensez-vous des obstacles scientifiques à la compréhension du mécanisme qui permet au cerveau de démêler les liens de cause à effet et à la modélisation de ce mécanisme en vue d’améliorer l’IA?

KONRAD KORDING : Toute histoire humaine, toute étude que vous lirez ou écrirez, est une histoire causale. On se demande toujours : « Comment une chose a-t-elle fait pour qu’une autre chose se produise?» Voilà comment pensent les êtres humains, c’est au cœur de notre nature. Mais si vous me demandez comment le cerveau fait de tels liens, je dois vous dire que nous n’en avons absolument aucune idée. Si je vous demande comment vous comprenez la relation de cause à effet dans une situation donnée, vous me répondrez probablement que quelqu’un vous l’a expliquée. Ou peut-être que vous comprenez parce que lorsque vous étiez enfant, vous vous amusiez à apprendre par essais et erreurs. Et puis il y a la troisième possibilité, celle de l’observation. Vous avez vu un rocher dévaler une montagne et endommager un arbre, et vous savez maintenant qu’un rocher peut endommager un arbre. Mais nous ne savons pas du tout comment le cerveau fait de tels liens. Le passage au domaine computationnel est donc extrêmement délicat.

Q : Vous avez travaillé à des stratégies permettant d’utiliser des systèmes d’apprentissage automatique pour modéliser la causalité. Pouvez-vous nous parler un peu de ce travail?

KK : Chaque être humain a fait l’expérience de la causalité de millions de façons. Nous donnons un coup de pied dans une pierre et ça fait mal. Nous lançons des pierres, nous sculptons des pierres et nous demandons à quelqu’un d’autre de le faire, et nous possédons toute cette expérience dans tous ces domaines de causalité. Notre objectif était de transposer cette logique dans un contexte d’apprentissage automatique. Il nous fallait donc une situation où réaliser un grand nombre d’expériences causales. Par conséquent, nous perturbons un microprocesseur simulé. À l’aide d’un fil, nous augmentons le courant dans les transistors et nous essayons diverses choses. C’est comme donner un coup de pied dans une roche, mais à l’échelle d’un transistor. Ensuite, sur la base de données telles que les traceurs temporels des transistors, nous voyons si nous pouvons prédire ce qui va se produire, et ce qui se passe dans le processeur. Nous faisons cela des milliers de fois, avec des milliers d’interactions dans les transistors pour entraîner le système. Nous essayons de voir si le système peut déterminer la causalité de l’autre côté, sans données d’entraînement supplémentaires.

Q : Nous avons vu des vidéos de robots apprenant à faire des choses banales et il faut souvent beaucoup de temps avant qu’ils ne maîtrisent des tâches simples. Pourquoi les robots semblent-ils si limités?

KK : Les êtres humains naissent avec beaucoup de connaissances préalables, ce qui n’est pas le cas des robots. Les êtres humains semblent comprendre naturellement les relations de cause à effet. Les travaux d’Alison Gopnik nous montrent de façon remarquable que les bébés veulent comprendre le monde en termes de causalité. Les robots et les systèmes d’IA actuels ne partagent pas ce préjugé intégré. Nous devons donc en forcer l’intégration en leur donnant une masse de données d’entraînement, sinon ils ne découvriront pas comment fonctionne le monde sur le plan de la causalité et ils seront vraiment impuissants. Cela signifie que nous avons besoin de beaucoup plus de données. En tant que spécialistes de l’IA, nous pensons que ce besoin de données est essentiellement destiné à compenser l’avantage évolutif qui a permis à l’être humain d’en arriver là où il est aujourd’hui.

« Ce que les gens doivent comprendre à propos des systèmes d’IA actuels, c’est qu’ils sont de très bons assistants, mais pas de véritables héros. »

– Konrad Kording

Q : En ce qui concerne la capacité de l’IA à rivaliser avec le cerveau humain, sur une échelle de 1 à 10, quelle est la probabilité que le domaine de l’IA donne lieu à l’IAG au cours des dix prochaines années?

KK : Je dirais deux. Presque tout le monde en IA pense que nous nous dirigeons vers cela. Mais il y a beaucoup d’incertitude quant au moment où nous y parviendrons : certains parlent de cinq ans, d’autres de cinquante ans. À mon avis, les gens doivent comprendre que l’IA n’est pas du tout comme les êtres humains. Elle ne pense pas comme nous. Elle pense très, très différemment, si on peut même parler de pensée. Je me demande même s’il s’agit d’un objectif souhaitable. Dans l’intelligence humaine, nous avons codé le type de données qui rend la société stable, même en temps de crise. Il y a des données codées sur la manière de sortir de l’impasse si l’on est coincé. Les systèmes d’IA ne peuvent pas faire cela, car les crises ne sont pas assez fréquentes pour l’IA. Votre génome raconte l’histoire de dix mille sécheresses et la manière d’y survivre. Les données émotionnelles et sociales qui sont intériorisées chez les êtres humains sont beaucoup plus profondes que ce que l’IA pourrait apprendre à partir d’un ensemble de données de base. Il n’existe pas de référentiel de données sur les 10 000 crises de l’humanité. Par ailleurs, l’IA est déjà meilleure que vous et moi à bien des égards, et ce depuis longtemps. Elle multiplie mieux les nombres et trouve mieux les livres, et cela ne nous pose aucun problème. Par conséquent, alors que certaines personnes pensent que l’IA va nous rendre obsolètes, je pense qu’elle va plutôt rendre obsolètes les aspects les plus banals de la vie. Ce que les gens doivent comprendre à propos des systèmes d’IA actuels, c’est qu’ils sont de très bons assistants, mais pas de véritables héros.

Articles liés

-

Le CIFAR accueille ou reconduit des titulaires de chaires en IA Canada-CIFAR

04 décembre 2025

-

Rendre l’IA plus sûre grâce à des méthodes d’évaluation avancées

03 décembre 2025

-

Le programme de bourses de recherche CIFAR Jacobs soutient la recherche de prochaine génération sur le développement et l’apprentissage de la petite enfance

24 novembre 2025

-

Le CIFAR lance de nouveaux réseaux axés sur la sécurité de l’IA afin de se pencher sur les inégalités linguistiques et sur les preuves synthétiques dans le système judiciaire

19 novembre 2025